windows2012安装教程

1、开机加载系统盘镜像

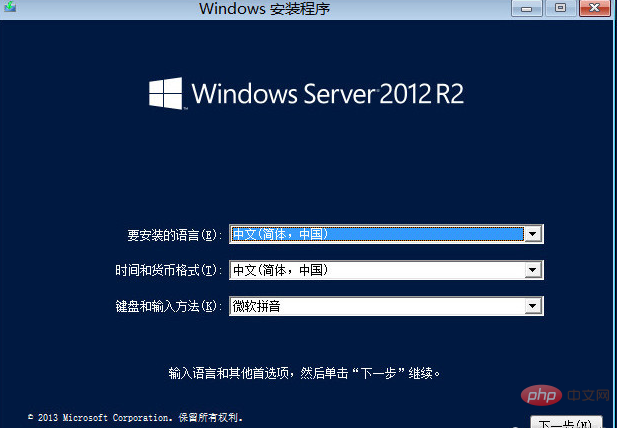

2、点击“下一步”

3、点击“现在安装”

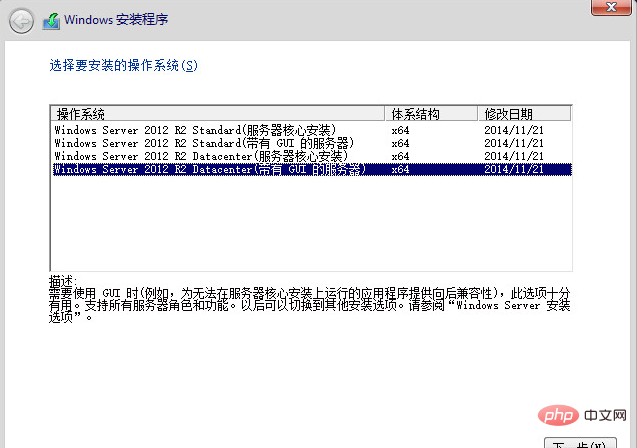

4、选择“windows Server 2012 R2 datacenter(带有GUI的服务器)”,点击下一步

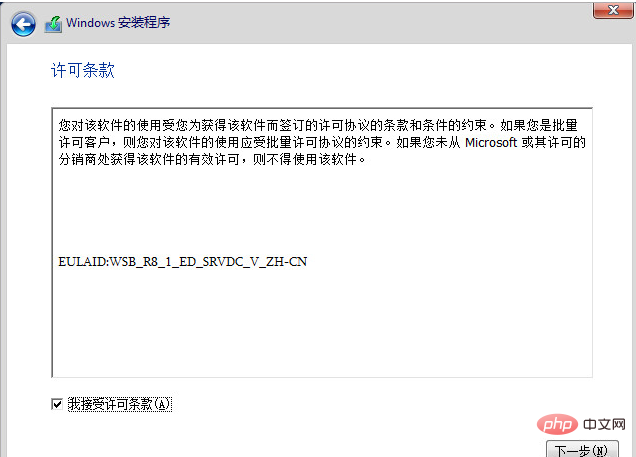

5、勾选“我结束许可条款”,点击“下一步”

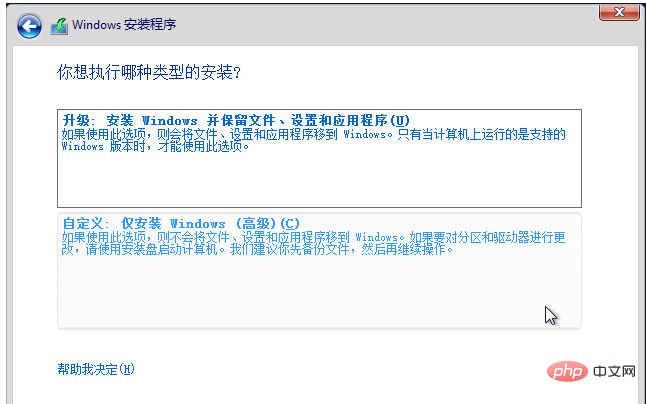

6、点击“自定义:仅安装windows(高级)”

7、选择“驱动器0未分配的空间”,点击“新建–>>应用–>>确定–>>下一步”

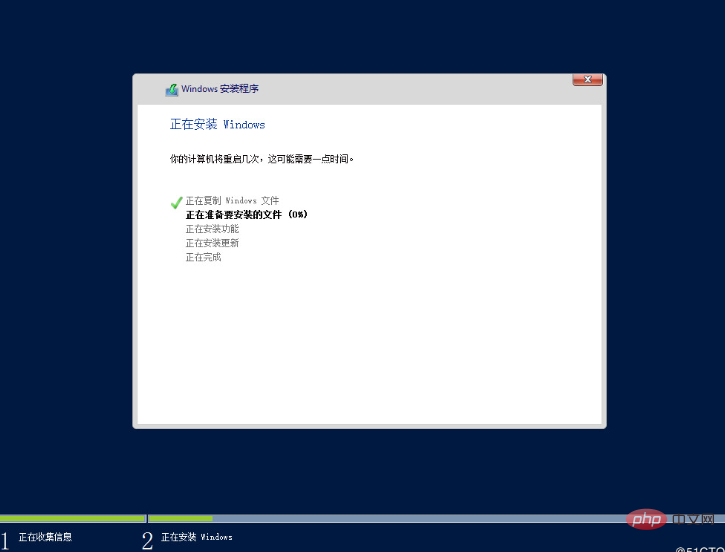

8、系统安装中 #等待时间大概30分钟,配置高服务器的时间会短一些

10、完毕。安装结束,后系统自动重启

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END