将linux环境下的kafka与hadoop集成,可以构建一个高效的大数据处理与分析平台。 这是一个复杂但回报丰厚的过程,需要仔细规划和执行。

集成步骤详解:

-

Hadoop集群搭建与配置: 首先,确保Hadoop集群(包含NameNode、DataNode和ResourceManager等核心组件)已正确安装并配置。所有节点间的网络通信必须畅通无阻,且各项参数设置准确无误。

-

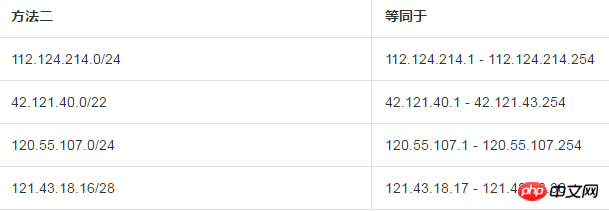

Kafka集群部署与配置: 安装Kafka软件包,创建必要的Kafka主题,并对Kafka Broker进行细致的配置。 尤其要注意Kafka Broker与Hadoop集群的通信参数设置,例如zookeeper地址等,必须准确无误。

-

Hadoop集成Kafka配置: 为了实现Hadoop与Kafka的互通,需要对Hadoop组件(如mapreduce、spark)进行配置,使其能够与Kafka进行数据交互。这通常需要修改Hadoop配置文件(例如core-site.xml、hdfs-site.xml和yarn-site.xml),并添加相应的Kafka参数。

-

MapReduce/Spark程序开发与运行: 完成Hadoop和Kafka集成后,即可编写MapReduce或Spark程序来处理数据。这些程序将Kafka作为数据源,读取数据、进行处理,并将结果写入HDFS或其他存储系统。

关键注意事项:

-

安全策略: 数据安全和隐私至关重要。建议配置Kafka的SASL认证和加密传输机制,保障数据安全。

-

性能调优: 根据实际业务需求,对Kafka和Hadoop进行性能优化。例如,调整Kafka的分区数和副本数,优化Hadoop的MapReduce任务配置等,以提升系统效率。

-

监控与日志: 集成完成后,持续监控Kafka和Hadoop的运行状态,确保系统稳定,并及时处理潜在故障。 完善的日志管理机制也必不可少。

通过以上步骤和注意事项,您可以成功集成Linux环境下的Kafka和Hadoop,构建一个功能强大、高效可靠的大数据处理和分析平台。