问题:

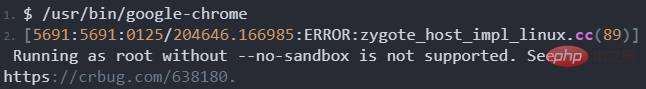

直接在Terminal中输入打开,提示如下信息:

(推荐教程:centos教程)

解决方法:

1、打开chrome浏览器的快捷方式文件

命令如下:

$ vi /usr/share/applications/google-chrome.desktop

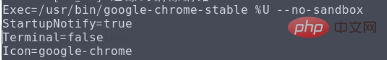

2、修改 Exec=/usr/bin/google-chrome-stable %U 在其后面加上 –no-sandbox

修改后如下图所示:

3、保存退出。

相关视频教程推荐:centos教程

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

喜欢就支持一下吧

相关推荐