window10无法连接wifi怎么办?

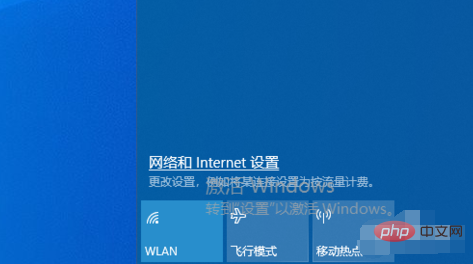

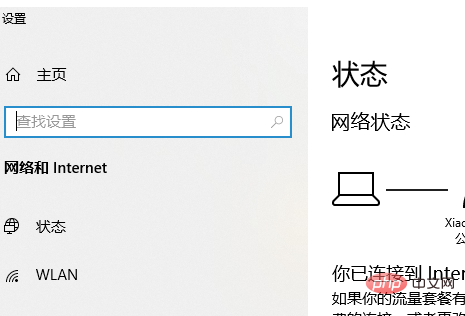

为了确保Win10能够正常连接无线WiFi,前提是电脑中内置了无线网卡、网卡驱动正常,并开启了无线功能。鼠标点击任务栏中的网络图标,选择网络和Internet设置。

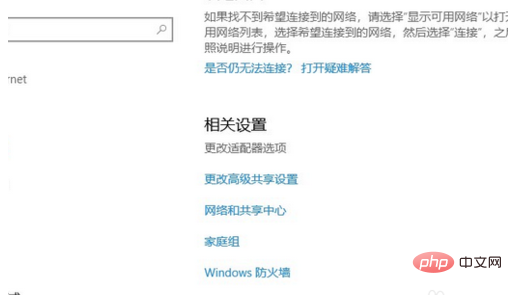

进入设置界面,点击更改适配器选项。

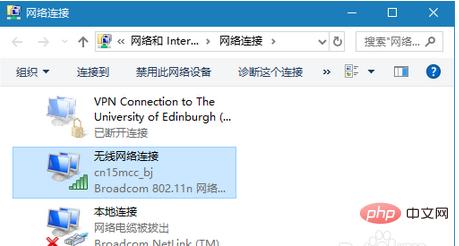

进入网络连接界面,双击需要连接的无线网络。

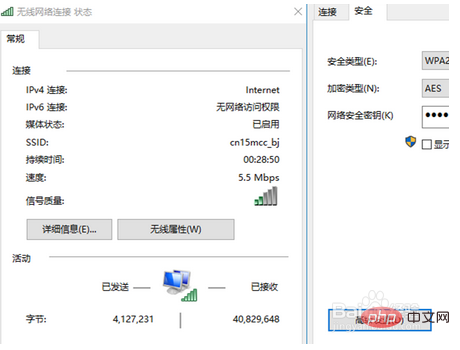

点击无限属性,然后进入无线网络属性界面,,点击安全,然后选择高级设置。

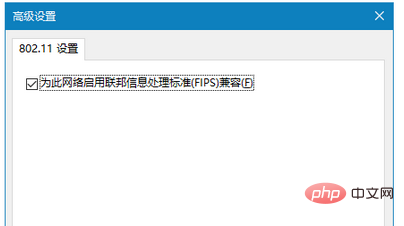

进入高级设置界面,勾选“为次网络启用联邦信息处理标准(FIPS)兼容”,点击确定。

断开WiFi,重新连接,即可正常使用无线网络了。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END