本文在介绍云服务器 ecs上如何删除一份自定义镜像的基础上,重点探讨了其具体步骤,本文内容紧凑,希望大家可以有所收获。

DeleteImage

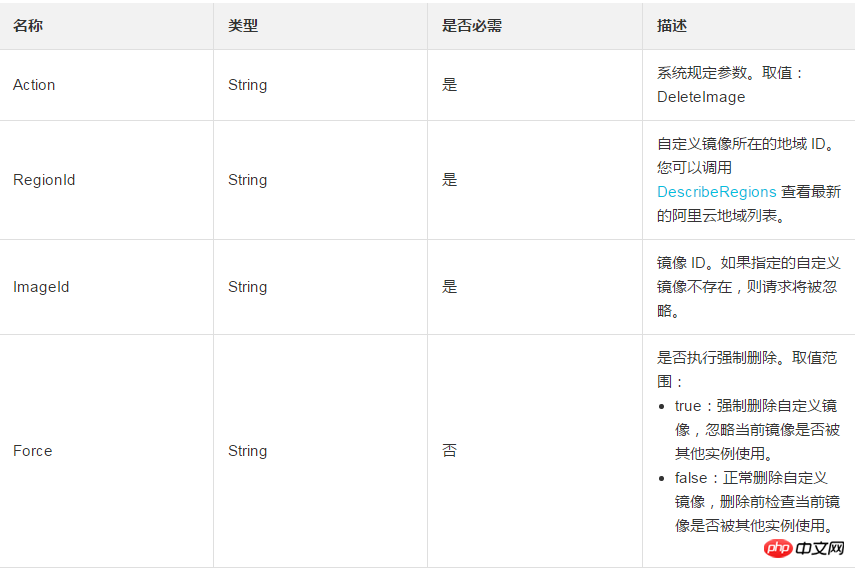

请求参数

返回参数

全是公共返回参数。参阅 公共参数

示例

请求示例

https://ecs.aliyuncs.com/?Action=DeleteImage &RegionId=cn-hangzhou &ImageId=m-63DFD5FB2 &

返回示例

xml 格式

<deleteimageresponse> <requestid>CEF72CEB-54B6-4AE8-B225-F876FF7BA984</requestid></deleteimageresponse>

json 格式

{ "RequestId": "CEF72CEB-54B6-4AE8-B225-F876FF7BA984" }

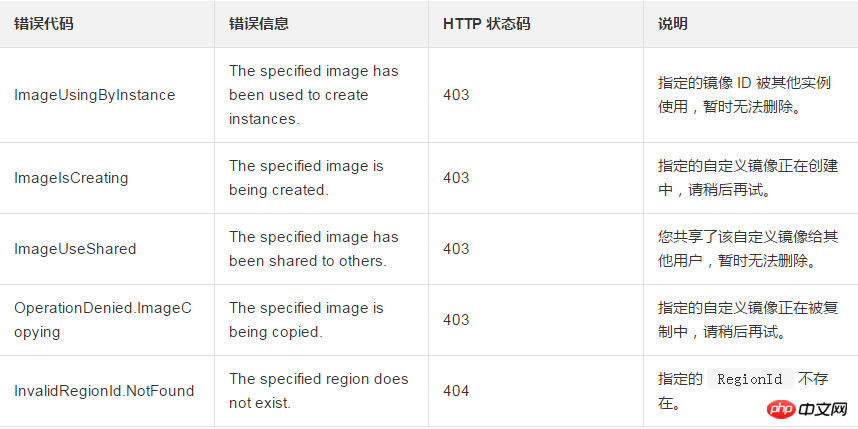

错误码

以下为本接口特有的错误码。更多错误码,请访问 API 错误中心。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END