(一)

问题描述:

ubuntu使用”apt-get install“安装程序时遇到错误提示:

you might want to run 'apt-get -f install' to correct these

解决方案:

使用如下命令修复安装包(不过在我遇到的问题中没有起作用)

$ sudo apt-get --fix-broken install

或者使用命令

$ sudo dpkg --purge xxx

其中xxx为安装失败的程序,错误提示中会给出其名称,不过也有可能是错误提示中未给出的,但之前安装的确出错的程序。

(二)

问题描述:

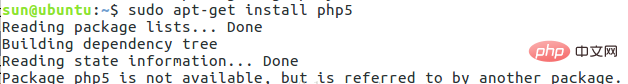

在使用Ubuntu安装软件时出现安装失败的情况如下(系统是虚拟机下新装的):

解决方法:

在命令行下一次输入:

sudo apt-get update (更新源)

按回车;然后再输入:

sudo apt-get install upgrade (更新已安装的包)

按回车;最后再使用安装命令:

sudo apt-get install‘软件名字’

这样就可以正常使用apt-get install 命令了!

(三)

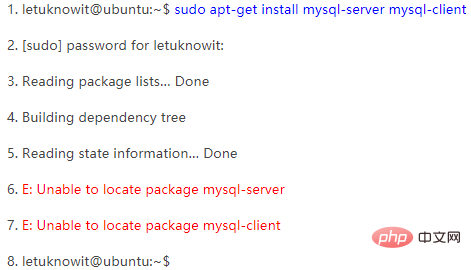

问题描述:

在虚拟机中装了个Ubuntu,当前的版本是Ubuntu 11.10,装好后自然少不了安装一些软件,在设置了软件的源后,就开始了 sudo apt-get install,结果出现了下面的Unable to locate package错误:

解决方法:

发现问题出在执行sudo apt-get install之前更换了软件源,但是却忘了update下了,于是执行下面的命令:

sudo apt-get update

等上面命令执行完后,再执行

sudo apt-get install

就可以了!

推荐教程:Linux教程

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

喜欢就支持一下吧