应用名称:楠图

应用版本:1.0

应用大小:17.6

适用平台:安卓

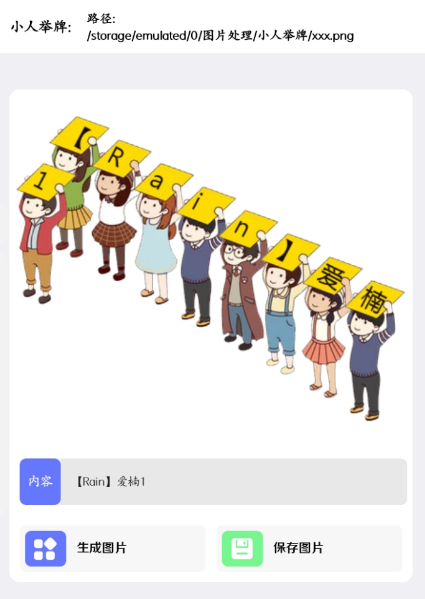

官方介绍:楠图是一款持续更新的图片处理工具,目前包含有 > 图片去色;图片字符化;图片加水印;九宫格切图;说说图片生成;隐藏文字图;小人举牌图;图片直链;图片取色;图片旋转;在线壁纸等工具。

下载地址:

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

应用名称:楠图

应用版本:1.0

应用大小:17.6

适用平台:安卓

官方介绍:楠图是一款持续更新的图片处理工具,目前包含有 > 图片去色;图片字符化;图片加水印;九宫格切图;说说图片生成;隐藏文字图;小人举牌图;图片直链;图片取色;图片旋转;在线壁纸等工具。

下载地址: